人工智能伦理问题:挑战与解决策略

一、引言

随着人工智能(AI)技术的飞速发展,我们的生活、工作乃至社会形态都发生了深刻变革。人工智能的广泛应用也带来了一系列伦理问题。这些问题不仅涉及到技术本身,还涉及到法律、道德以及社会等多个层面。如何认识和解决这些问题,已经成为当下亟待探讨的重要议题。

二、人工智能伦理问题的多样性

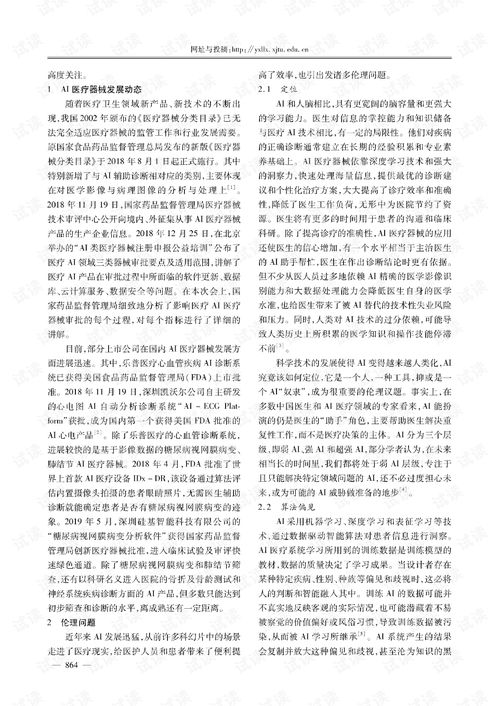

1. 数据隐私和安全:人工智能技术的应用往往需要大量数据进行训练。如何在确保数据隐私和安全的前提下,实现数据的高效利用,是我们需要面对的第一个伦理问题。

2. 不平等和歧视:AI算法的决策可能产生不公平的结果,从而加剧社会不平等。例如,某些AI系统可能在招聘、信贷审批等过程中产生歧视,这些问题需要我们关注并解决。

3. 自动化和就业:随着AI技术的普及,许多工作可能被自动化取代,这可能导致大量失业。如何在实现技术进步的同时,保障人民的就业权利,是我们需要面对的另一个重要伦理问题。

4. 责任和问责:当人工智能系统出现错误或产生不良后果时,如何追究责任?应该由谁来承担责任?这些问题都涉及到AI伦理中的责任和问责机制。

三、国际和国内的人工智能伦理规范

1. 国际规范:在国际层面,一些组织和国家已经开始制定AI伦理规范。例如,欧盟的人工智能伦理准则旨在确保AI的应用符合基本的人权、公平、透明和非歧视原则。联合国教科文组织也发布了人工智能伦理建议书,呼吁各国在AI的发展和应用中,重视人类价值观和社会公义。

2. 国内规范:中国作为全球人工智能发展的重要力量,也在积极探索AI伦理问题的解决之道。国家新一代人工智能治理专业委员会发布的新一代人工智能伦理规范提出了一系列针对人工智能研究和应用的伦理要求。同时,网络安全法、数据安全法等法规也为人工智能的规范应用提供了法律依据。

四、解决人工智能伦理问题的策略

1. 强化法律法规:通过立法手段,明确人工智能活动中的法律责任和道德准则,为AI的健康发展提供法制保障。同时,要加强对AI违法行为的惩处力度,形成有效的威慑。

2. 倡导透明和可解释性:为了防止AI系统的“黑箱”操作,我们需要倡导透明和可解释性原则。这意味着AI系统的决策过程应该是透明的,用户应该能够理解AI系统的决策依据和逻辑。

3. 促进包容性和公平性:在设计和开发AI系统时,需要考虑到不同群体(如性别、种族、文化背景等)的需求和特点,避免产生歧视和不公平的结果。同时,政府和企业应采取措施,确保所有人都能平等地受益于人工智能技术的发展。

4. 加强教育和培训:提高公众对AI伦理问题的认识和理解,通过教育和培训增强人们的人工智能伦理意识。这包括对科技从业人员的教育和培训,以及面向大众的AI伦理教育。

5. 建立多方参与的治理机制:政府、企业、学术界和社会各界应共同参与人工智能的治理,形成有效的合作机制。通过多方参与,我们可以共同面对和解决人工智能伦理问题,推动人工智能技术的健康、可持续发展。