人工智能的伦理学问题

一、人工智能的基本概念

人工智能(Arificial Ielligece, AI)是一种模拟人类智能的技术,它涉及计算机科学、数学、心理学、哲学等多个领域。人工智能的主要目标是让机器能够像人类一样思考、学习、推理和决策,从而完成各种复杂的任务。随着人工智能技术的飞速发展,越来越多的领域开始应用人工智能技术,如医疗、金融、交通、军事等。

二、人工智能伦理问题的产生

人工智能技术的发展带来了许多便利和进步,但同时也带来了一些新的伦理问题。其中最主要的问题是人工智能是否应该拥有道德和伦理的地位,以及它对人类道德观念的影响。

人工智能是否应该拥有道德和伦理的地位是一个根本性的问题。目前,人工智能技术还无法完全模拟人类的道德和伦理判断,因此,当人工智能做出决策时,我们无法保证其决策的道德性和公正性。例如,在自动驾驶汽车的设计中,当面临必须撞到行人还是撞到其他车辆的情况时,人工智能如何做出决策?这是一个非常复杂和敏感的伦理问题。

人工智能对人类道德观念的影响也是一个重要的问题。随着人工智能技术的普及,人们开始依赖机器的决策,甚至开始将某些责任和义务转交给机器。例如,在医疗领域,一些医生开始使用人工智能技术进行诊断和治疗,这在一定程度上削弱了医生的责任和义务。人工智能技术还可能带来一些新的道德问题,如数据隐私、信息泄露等。

三、人工智能的伦理问题及影响

1. 数据隐私和信息泄露

人工智能技术需要大量的数据支持,而数据的收集和使用往往涉及到用户的隐私和信息安全。一些人工智能公司可能会在收集和使用数据的过程中泄露用户的隐私和信息,给用户带来损失。一些黑客可能会利用人工智能技术进行网络攻击和诈骗,进一步威胁到用户的隐私和信息安全。

2. 歧视和不公平

人工智能技术在某些情况下可能会产生歧视和不公平的现象。例如,一些金融机构可能会使用人工智能技术对客户进行信用评估和贷款审批,但这些评估标准可能会存在偏见和歧视,导致某些人群无法获得公平的贷款机会。一些政治和社会领域也存在着利用人工智能技术进行不公平选举和社会管理的风险。

3. 责任和义务的模糊

随着人工智能技术的普及,人们开始将一些责任和义务转交给机器。例如,在自动驾驶汽车的设计中,当车辆发生事故时,责任应该由谁承担?是车辆的所有者还是车辆制造商?在医疗领域,当医生使用人工智能技术进行诊断和治疗时,如果出现问题,责任应该由谁承担?这些问题涉及到许多复杂的伦理和法律问题。

四、如何解决人工智能的伦理问题

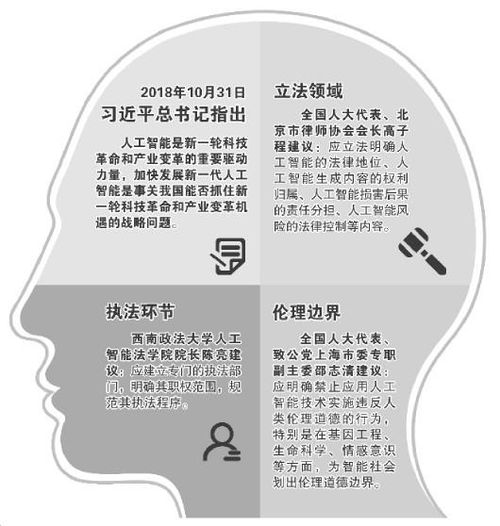

1. 制定严格的法律法规

政府应该制定严格的法律法规来规范人工智能技术的发展和应用。这些法律法规应该明确规定人工智能技术的使用范围和限制条件,同时也要明确相关人员的责任和义务。政府还应该加强对人工智能技术的监管和管理,确保其安全性和可靠性。

2. 加强伦理教育和培训

加强伦理教育和培训是解决人工智能伦理问题的关键措施之一。通过对相关人员进行培训和教育,可以提高他们对人工智能技术的认识和理解,增强他们的伦理意识和责任感。同时也可以提高他们对数据隐私和信息安全的认识和保护能力。

3. 促进透明度和可解释性

促进透明度和可解释性是解决人工智能伦理问题的关键措施之一。透明度是指机器决策的过程和结果应该对用户公开透明;可解释性是指机器决策的过程和结果应该能够被人类理解和解释。通过提高透明度和可解释性可以增强用户对机器决策的信任和理解。