人工智能伦理问题:挑战与解决方案

1. 引言

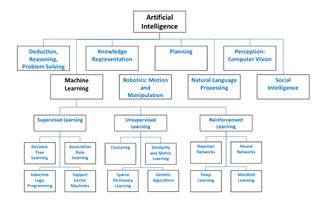

随着科技的快速发展,人工智能(AI)已经深入影响到我们的日常生活。从自动驾驶汽车到智能家居,从医疗诊断到预测分析,AI的应用几乎无处不在。随着AI的普及,一系列伦理问题也逐渐浮现。本文将探讨人工智能定义及其伦理问题,包括数据隐私与安全、偏见与歧视、自动化与就业、人机交互与人类价值观、人工智能的决策过程透明性,以及未来展望与政策建议。

2. 人工智能定义与伦理问题

人工智能是指通过计算机程序和算法模拟人类的智能行为和思维过程。伦理问题主要是指在开发和运用人工智能过程中,产生的与道德、价值观和人类利益相关的问题。例如,当AI系统决策可能对人类造成伤害时,我们应该如何权衡?又如,当AI系统模仿人类行为时,它是否应承担道德责任?

3. 数据隐私与安全

AI系统的训练和使用需要大量的数据支持。数据的收集、储存和使用过程中存在隐私和安全风险。例如,未经授权的数据访问、数据泄露和数据滥用等。为了解决这些问题,我们需要加强数据安全和隐私保护的法律法规,以及提高数据使用者的道德责任感。

4. 偏见与歧视

AI系统的训练数据往往来自人类社会,而社会中的偏见和歧视很可能会被“反映”在AI系统中。这可能导致不公平的结果,如不准确的犯罪预测、就业歧视等。为了消除偏见和歧视,我们需要采取一系列措施,包括数据清洗、公平性评估、算法审计等。

5. 自动化与就业

随着AI的普及,许多工作可能会被自动化取代。这可能导致失业问题,特别是对那些低技能的工作者。为了解决这个问题,我们需要重视职业教育和技能培训,以提高劳动力的适应性和竞争力。同时,政策制定者也需要考虑如何创造新的就业机会和职业路径,以减少自动化对就业市场的冲击。

6. 人机交互与人类价值观

AI系统越来越多地被用于人机交互。当AI系统与人类价值观发生冲突时,我们应该如何处理?例如,当AI系统推荐的治疗方案与医生的临床判断不一致时,我们应该听从谁的意见?为了解决这个问题,我们需要建立人机交互的伦理框架,明确AI系统在决策中的角色和责任。

7. 人工智能的决策过程透明性

透明性是道德决策的基础。许多AI系统的决策过程往往缺乏透明性。这使得人们难以理解AI系统的决策依据和过程,也增加了决策的不确定性。为了解决这个问题,我们需要提倡透明性的重要性,并制定相关法律法规要求AI系统提供足够的透明度。

8. 未来展望与政策建议

面对人工智能的伦理挑战,我们需要在科技进步和道德伦理之间找到平衡点。为此,政策制定者需要在推动AI发展的同时,制定相应的伦理指南和政策措施。例如,建立独立的AI伦理委员会来监督和管理AI系统的开发和运用;加强AI教育和培训,提高公众对AI伦理问题的认识和理解;制定严格的法律法规,严惩违反伦理的行为等。

9. 结论

人工智能的发展带来了许多机遇和挑战。其中最紧迫的问题之一就是人工智能的伦理问题。为了确保AI技术的可持续发展和人类的利益最大化,我们需要在科技进步和道德伦理之间取得平衡。这需要所有利益相关者的共同努力:政策制定者需要制定明智的政策和法规;科研人员需要承担起道德责任;企业需要秉持社会责任;公众也需要提高对AI伦理问题的认识和理解。只有这样,我们才能充分利用人工智能的优势,同时避免或减少其潜在的负面影响。