人工智能伦理学的未来发展

一、人工智能伦理学的背景

随着人工智能技术的飞速发展,人工智能在各个领域的应用越来越广泛。与此同时,人工智能伦理学的问题也逐渐浮现。人工智能伦理学主要研究如何规范人工智能技术的使用,以确保人工智能的发展符合人类的价值观和道德标准。

二、人工智能伦理学的基本概念

人工智能伦理学主要包括以下几个方面:

1. 道德责任:指在使用人工智能技术时,应该明确相关责任,包括开发者的责任、使用者的责任等。

2. 公正性:指在应用人工智能技术时,应该避免歧视和不公平现象,确保技术的公正性。

3. 透明性:指人工智能系统的决策过程应该透明,确保人们能够理解并信任系统的决策。

4. 可追溯性:指人工智能系统的决策过程应该可追溯,以便在出现问题时能够进行调查和解决。

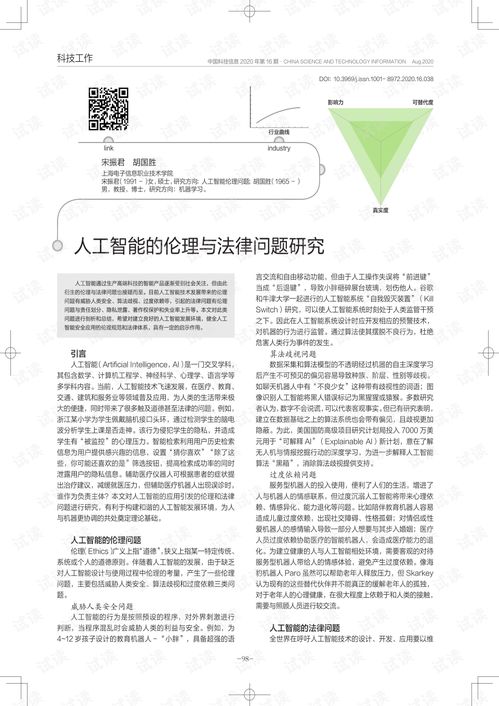

三、人工智能的伦理问题

人工智能的发展带来了一系列的伦理问题,主要包括:

1. 数据隐私:人工智能技术需要大量的数据支持,但数据的收集和使用可能会侵犯个人隐私。

2. 歧视和不公平:人工智能系统可能会出现偏见和歧视现象,导致不公平的结果。

3. 自主决策:人工智能系统能够自主决策,但这些决策是否符合人类的价值观和道德标准需要进一步探讨。

四、人工智能伦理学的研究方法

为了解决上述伦理问题,人工智能伦理学的研究方法主要包括:

1. 规范研究:研究如何制定规范和标准来规范人工智能技术的使用。

2. 实证研究:通过实证方法研究人工智能技术的实际应用效果,以便更好地发现问题和解决问题。

3. 技术研究:研究如何改进人工智能技术本身,以减少潜在的伦理问题。

4. 法律研究:研究如何通过法律手段来规范和约束人工智能技术的发展和应用。

五、结论:人工智能伦理学的未来发展

随着人工智能技术的不断发展,人工智能伦理学将会越来越受到关注。未来,人工智能伦理学将会更加深入地研究如何规范人工智能技术的使用,以确保人工智能的发展符合人类的价值观和道德标准。同时,随着技术的不断进步和应用场景的不断扩展,人工智能伦理学将会面临更多新的挑战和问题,需要不断探索和研究。