人工智能伦理学问题研究

1. 引言

随着科技的快速发展,人工智能(AI)已经深入影响到我们生活的方方面面。随着AI的普及和应用,一系列伦理学问题逐渐浮现。AI伦理学,作为人工智能研究的一个重要领域,旨在探讨和解决这些问题。本文将就人工智能伦理学进行概述,并针对面临的问题提出解决策略。

2. 人工智能伦理学概述

2.1 人工智能伦理学的定义

人工智能伦理学是指与人工智能相关的道德、伦理和价值观的研究和实践。它旨在确保AI的设计、开发和使用过程中,遵循公平、公正、透明等原则,同时不侵犯人类权益和尊严。

2.2 人工智能伦理学的分类

根据应用场景的不同,人工智能伦理学可分为两大类:弱人工智能伦理学和强人工智能伦理学。弱人工智能伦理学主要关注在AI应用过程中,如何确保人类的权益和尊严不受侵犯;强人工智能伦理学则更侧重于AI自身的道德和价值观问题。

2.3 人工智能伦理学的研究内容

人工智能伦理学的研究内容包括:数据隐私保护、算法公平性、人类与机器的界限、决策透明度等。这些议题旨在确保AI技术的健康发展,避免滥用和不公正现象。

2.4 人工智能伦理学的发展趋势

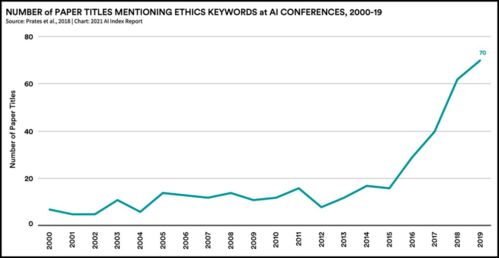

随着AI技术的不断进步,人工智能伦理学的发展趋势逐渐明朗。未来,AI伦理学将更加注重实践应用,与政策制定、法律监管等相结合,共同推动AI技术的可持续发展。

3. 人工智能伦理学面临的问题

3.1 数据隐私泄露问题

在AI应用过程中,数据隐私泄露是一个严重的问题。用户个人信息被泄露的风险随着大数据技术的广泛应用而增加。如何确保用户数据的安全和隐私,防止信息被滥用,是AI伦理学亟待解决的问题。

3.2 算法歧视问题

算法歧视是指在AI算法决策过程中,由于数据集的偏见或算法设计的不完善,导致不公平、不公正的结果出现。如何消除算法歧视,确保公平性和公正性,是人工智能伦理学的重要议题。

3.3 人类与机器的界限模糊问题

随着AI技术的不断发展,人类与机器的界限逐渐模糊。一方面,人类对机器的依赖程度不断提高;另一方面,机器正在逐渐具备人类的某些能力和特质。如何在确保人类权益的同时,发挥机器的优势和价值,是人工智能伦理学需要关注的问题。

3.4 机器决策透明性问题

在AI决策过程中,透明度是一个关键问题。由于算法黑箱的存在,人们往往无法了解AI决策的具体过程和依据,这使得人们对其信任度降低。如何提高决策透明度,增强公众对AI技术的信任,是人工智能伦理学的重要研究内容。

4. 解决人工智能伦理学问题的策略

4.1 完善法律法规,加强监管力度

政府应制定和完善与AI相关的法律法规,强化对AI技术的监管力度。通过制定严格的制度和规范,确保AI技术的合理使用和人类权益的保障。同时,对于违反规定的行为,应依法予以严惩。

4.2 倡导公平公正,消除算法歧视

在AI算法设计和使用过程中,应倡导公平公正原则,消除算法歧视。通过改进数据集和提高算法设计的公正性,降低不公平结果出现的可能性。应建立相应的审查机制,对算法进行定期评估和审查,以确保其公正性。